- 安装clash

sudo pacman -S clash

- 配置文件,external-ui需要单独安装

port: 7890 socks-port: 7891 redir-port: 7892 mixed-port: 7893 allow-lan: false mode: Rule log-level: info ipv6: false external-controller: 0.0.0.0:9090 external-ui: dashboard

安装dashboard,从https://github.com/haishanh/yacd下载最新解压即可

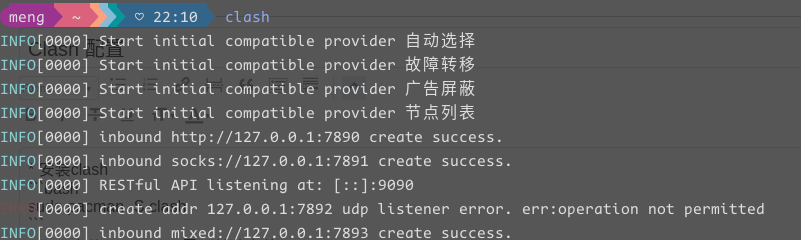

启动测试

clash

- 开机自启

sudo vim /etc/systemd/system/clash.service

[Unit] Description=Clash daemon, A rule-based proxy in Go. After=network.target [Service] Type=simple Restart=always ExecStart=/usr/bin/clash -d /etc/clash [Install] WantedBy=multi-user.target

sudo systemctl enable clash sudo systemctl start clash